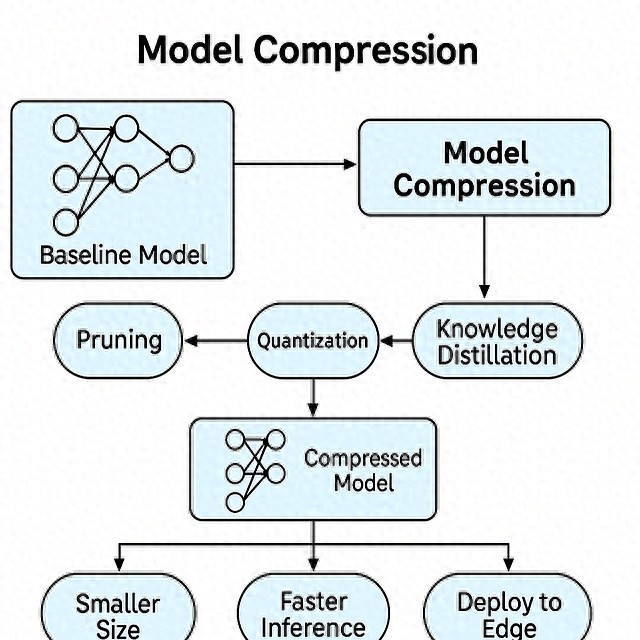

手机装不下大模型?别急着换机,先把模型“瘦身”再说。

剪枝、量化、蒸馏,听起来像实验室里的黑话,其实就是给AI减肥的三板斧。

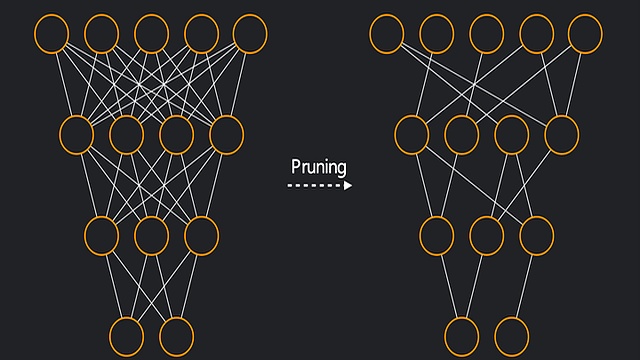

先剪枝:把模型里那些几乎不工作的连接咔嚓掉,60%的“赘肉”说扔就扔,精度只掉不到3%,比节食靠谱多了。

再量化:把32位的小数压缩成8位整数,模型瞬间瘦成四分之一,内存带宽直接省四分之三,跑起来像开了加速器。

最后蒸馏:让大模型当老师,把知识灌给小模型,学生只有老师十分之一的体重,速度却快三倍,成绩还只降两分,简直学霸养成记。

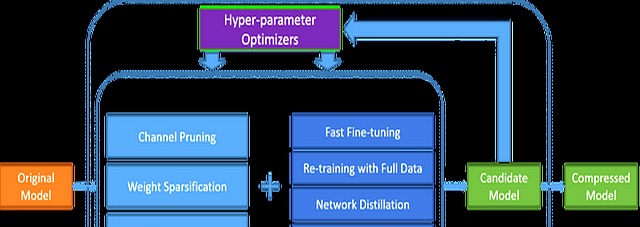

组合拳更狠:先蒸馏出小个子,再剪再压,一口气缩10到20倍,老手机也能跑新AI。

边缘设备才是主战场。

摄像头、手环、扫地机那点算力,根本喂不饱原版大模型,压缩后的“迷你AI”反而成了刚需。

新招也在路上:自适应剪枝能边看数据边减肥,动态量化实时调精度,像给模型装了自动变速器。

不想手动调?NNI、这类自动化框架一键帮你找最佳压缩方案,省得熬夜调参。

硬件也在配合,A100已经支持稀疏计算,剪掉的地方直接跳过,不浪费一丝电。

一句话总结:模型压缩不是炫技,是让AI真正跑进日常设备的通行证。

以后在电梯里、在地铁上,甚至在山里露营,都可能被一枚指甲盖大小的芯片默默服务。

别小看这几兆字节的差距,它决定了AI能不能从云端走下来,陪你一起挤早高峰。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...