什么是MCP?

MCP全称Model ,翻译过来就是:模型上下文协议。本质上就相当于一门标准化的“语言”,能让AI模型及大模型应用能更好地和调用外界数据源和工具。

它最早由人工智能明星公司创建,初衷在于推动旗下AI大模型产品和外部工具/服务更好地实现业务联动。

不过随着MCP在拓展大模型能力上带来的便利越发显而易见,加上2024年11月大手一挥,直接将其开源,MCP吸引到越来越多主流平台和应用接入,并逐渐成为AI连接的通用标准。

据不完全统计,目前包括、谷歌、微软、亚马逊、百度智能云、阿里云、腾讯云、字节、、、(排名不分先后)等在内都有官宣接入MCP。

随着AI服务商纷纷拥抱MCP,它也在短短数月之内成了主流大模型及很多基于大模型应用的协议“标配”。

MCP如何运作?

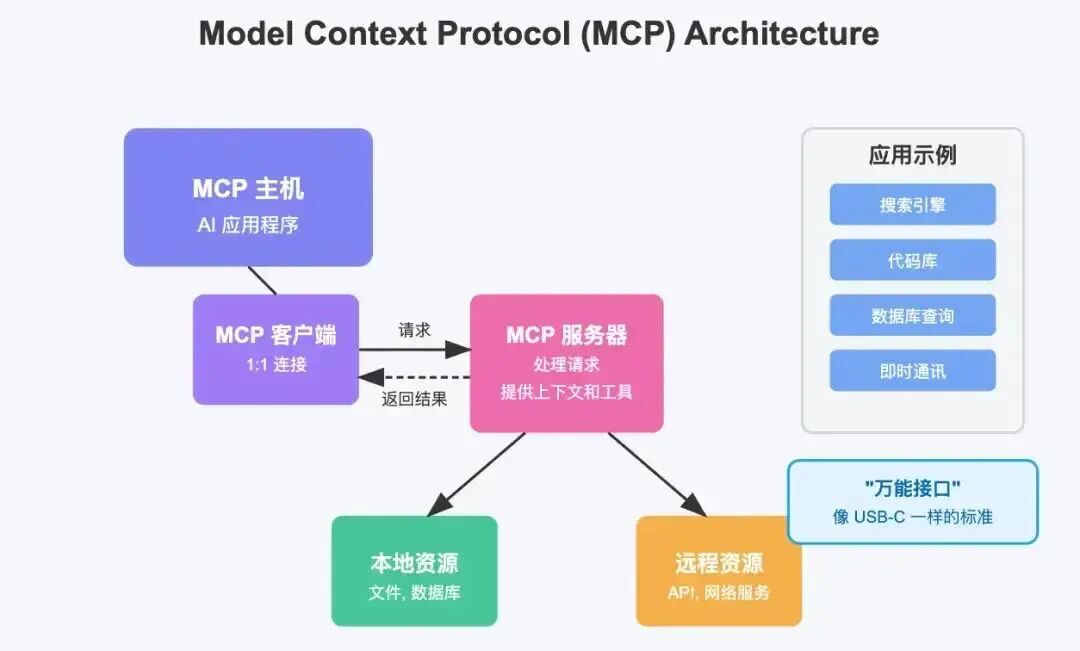

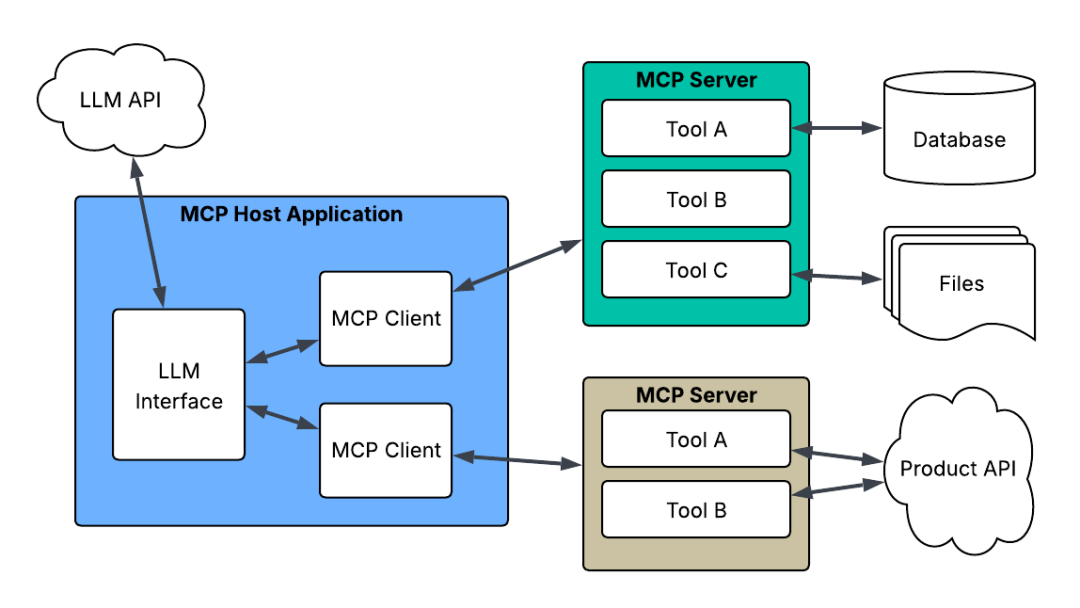

目前MCP包含三大核心组件:MCP Host(MCP 主机)、MCP (MCP客户端)和MCP (MCP 服务器)。

其中MCP Host(主机)集成了LLM的各种应用程序(如桌面应用、IDE工具、Web应用等),负责发起请求并管理用户交互。MCP (客户端)位于Host内部,顾名思义就是客户端使用入口,负责将客户请求发送到MCP 服务器,处理协议通信。MCP (服务器) 主要负责根据客户端请求调用各种资源和工具(除外部资源,还包含本地资源及远程资源),并返回相应的结果或数据。

三者相互配合,确保了大语言模型能根据上下文,自主、便捷、统一地调用各类数据资源和工具服务,从而推动各类任务场景更好地完成和实现。

MCP 由三个关键组件构成:

元数据管理:动态追踪数据来源与状态,确保数据的可溯源性和可靠性。

关系映射:定义模型间的依赖与协作规则,使不同系统能够理解彼此的数据结构和操作逻辑。

动态适配:支持跨平台、跨场景的数据一致性,确保数据在不同环境中的表现形式保持一致。

MCP与传统API协议的区别

与传统 API 相比,MCP 提供了更轻量级的上下文描述能力,无需复杂的接口定义即可实现系统间的通信。它与数据湖/仓解决方案并不冲突,而是形成互补关系,增强数据交互的上下文感知能力。

关注睿伴机器人

相关文章