“模型跑通那天,老板一句‘上线’,差点把显卡风扇吓停。

这不是段子,是真事。

训练好的.pth文件躺在服务器里,像刚考完驾照的新手,没人敢让它独自上路。

今天聊的,就是把这位“新手”塞进车里、挂好牌照、让它在真实路况里不熄火的全过程。

先说最扎心的:模型不是“保存”就能用,得先学会“搬家”。

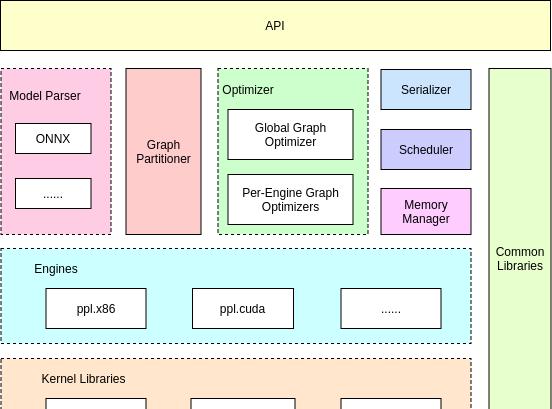

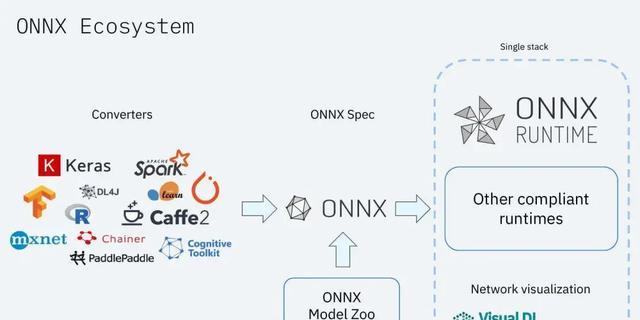

.pth文件像一屋子家具,ONNX就是集装箱。

把家具拆成标准件,才能塞进不同卡车。

官方教程里那句“torch.onnx.”看起来人畜无害,实际踩坑率90%。

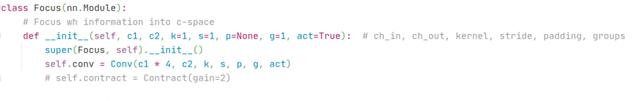

比如的层,自带一堆,ONNX直接罢工,得把逻辑拆出来,像给猫洗澡——按住、冲水、速战速决。

拆完逻辑,还得处理“小脾气”。

SiLU激活函数在里叫“Swish”,名字不一样,功能一样,但老版本不认识。

解决办法简单粗暴:导出时把SiLU换成ReLU,精度掉一点,速度提一截,老板问起来就说“做了轻量化”。

真正让人头秃的是后处理。

NMS(非极大值抑制)这玩意,论文里三行公式,代码里三百行bug。

用numpy写,CPU跑得比地铁早高峰还挤;换成C++ ,瞬间变高铁。

关键是别用深度学习框架自带的NMS,那玩意像背着全家去旅行,重得离谱。

自带,一行代码搞定,省下的时间够下楼买杯咖啡。

有人问了:、不是更快?

确实快,但配置起来像装修。

ONNX转.bin/.xml那一步,错一个参数就得重来。

属于“拎包入住”,、树莓派、甚至十年前的工控机都能跑。

客户现场没网?

拷个.dll就能演示,比解释“CUDA版本不匹配”轻松多了。

最后说个玄学:量化。

INT8量化像给模型节食,瘦是瘦了,但可能饿出幻觉。

实测量化后,猫狗都能认成袋鼠。

折中方案是部分量化:用INT8,检测头留FP16,精度损失肉眼不可见,速度提升肉眼可见。

模型部署没有银弹,只有“能跑就行”的哲学。

下次老板再说“明天上线”,至少知道先转ONNX,再拆后处理,最后留半小时测试NMS阈值。

真出bug?

把锅甩给动态形状,反正ONNX也不支持。

相关文章