是一种在自然语言处理以及更广泛的序列建模任务中被广泛采用的深度学习架构,由等人在2017年的论文《 is All You Need》中首次提出。与以往的序列模型不同,最大的创新之处在于彻底摒弃了循环神经网络(RNN)和卷积神经网络(CNN)等传统结构,完全依赖一种被称为自注意力机制的方法来建模序列中不同位置之间的依赖关系。

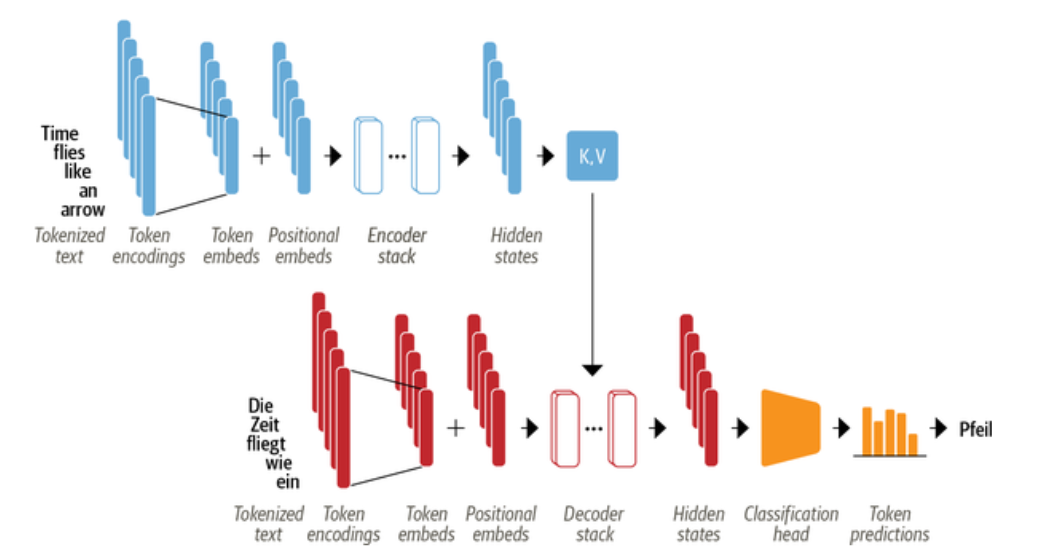

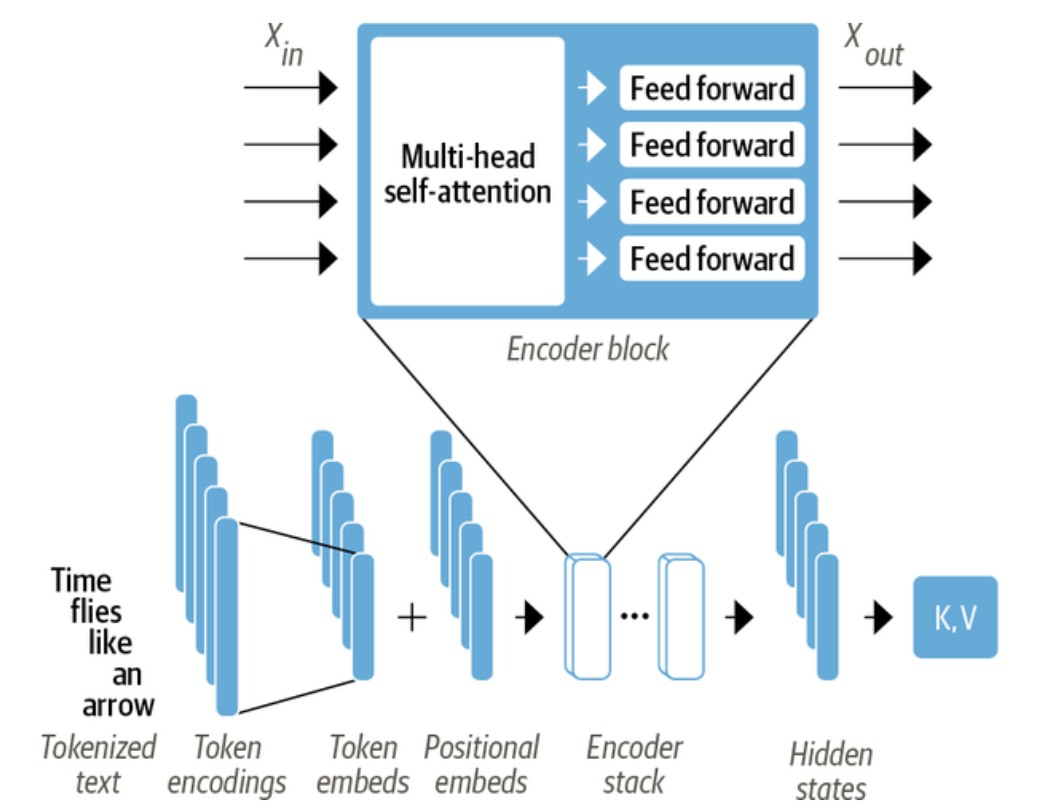

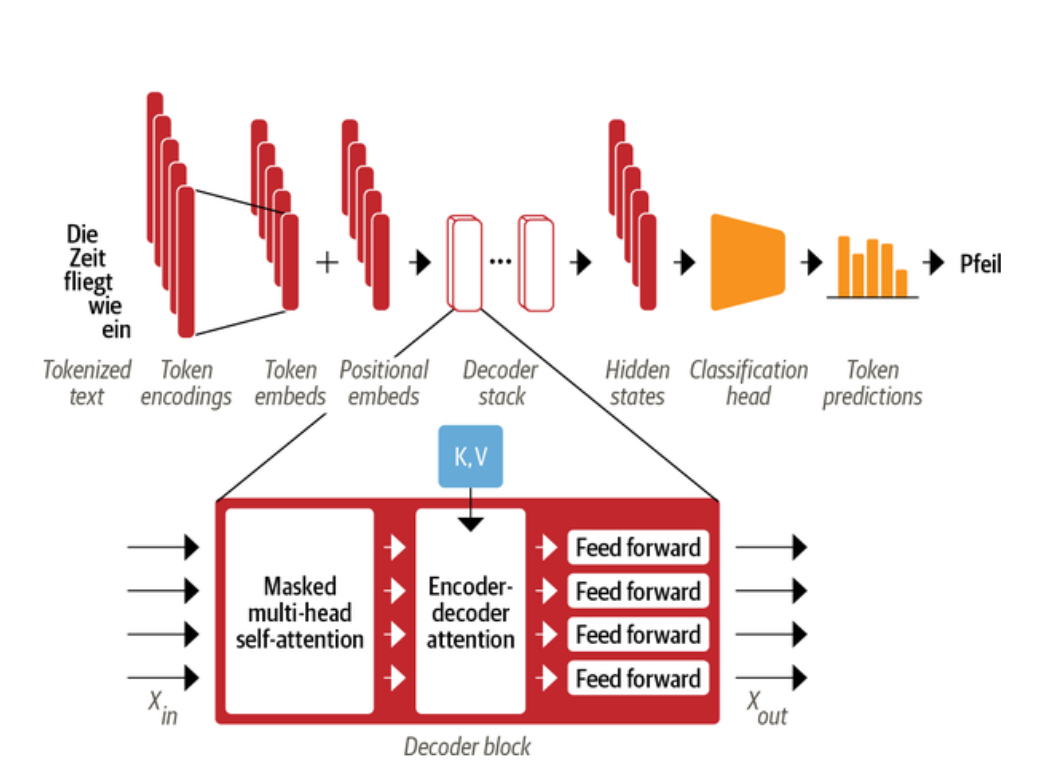

基于编码器-解码器架构,该架构广泛用于机器翻译等任务中,即将一个单词序列从一种语言翻译成另一种语言。该架构由如图1所示的几个构建块组成。图1中展示了整体的编码器-解码器结构,各模块之间通过注意力机制相互作用,实现从输入到输出的转换。

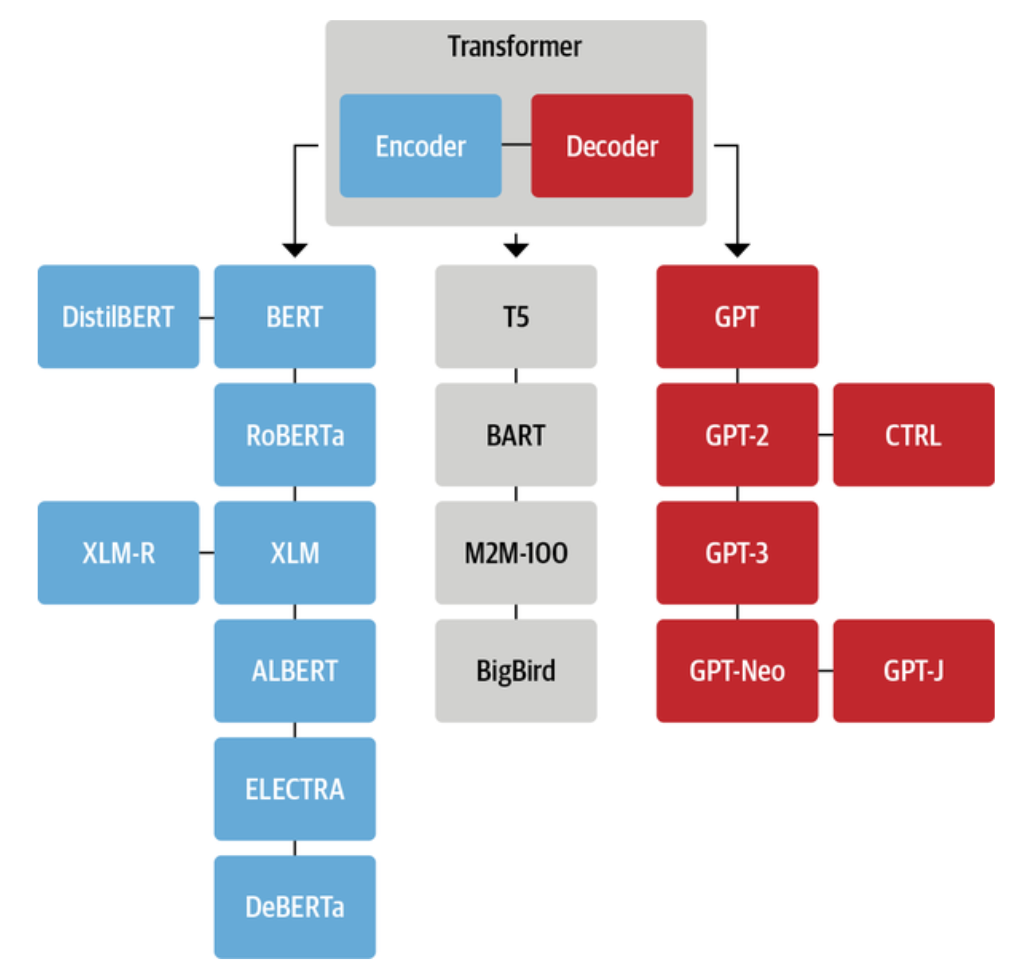

架构最初是为序列到序列的任务(如机器翻译)而设计的,但编码器和解码器模块很快就被抽出来单独形成模型。虽然模型已经有数百种不同的变体,但其中大部分属于“纯编码器”、“纯解码器”以及“编码器-解码器”三种类型之一。

纯编码器

纯解码器

这类模型用于对一个文本序列到另一个文本序列的复杂映射进行建模。它们适用于机器翻译和摘要任务。除了架构,它将编码器和解码器相结合,BART和T5模型也属于这个类。

总结

总的来说,架构在诞生后的几年间,研究人员不断在不同规模、不同类型的数据集上进行探索,尝试设计新的预训练目标,并在结构上进行改进与优化。这些努力催生了数百种不同的变体,虽然它们在细节设计、训练方式和应用领域上各不相同,但从整体结构来看,依然可以归纳为三大类,如图所示。

的出现彻底改变了深度学习对序列数据的处理方式。它以自注意力机制取代传统的循环和卷积结构,让模型能够在一次计算中捕捉全局依赖关系,并通过高度并行化显著提升训练与推理效率。

这种设计不仅解决了长距离依赖难题,还为大规模预训练模型的发展奠定了基础,使NLP、计算机视觉、语音识别等领域都迎来了性能飞跃。

在应用上,纯编码器适合信息提取类任务,如文本分类、情感分析;纯解码器专注生成式任务,如对话、内容创作;编码器-解码器则擅长翻译、摘要等序列到序列任务。

未来, 的研究将聚焦于提升长序列处理效率、优化低资源场景表现,并探索与领域知识的深度融合,从而在更多实际应用中展现更强的价值与生命力。

郑重申明:

由于每个人的体质和病情不同,本案中的治疗方案仅适用于本案病人当时的病情。未经中医辨证诊治,不得完全照搬本案中的治疗方案。广大读者如有需要,应前往正规医院诊治,以免贻误病情。

//写在最后:

乾医, 师从伏病派创始人田胜利博士。欢迎中医爱好者、医师、中医产品供应商的加入,期望能一起交流,相互学习,聚焦于祖国医学的数字化、标准化、客观化。如果有喜欢中医的朋友,可以加我好友,学海无涯,同行致远!!!

好文推荐:

相关文章