我跟你讲, 语义理解这件事, 对我来说既像修桥又像做菜. 我是一名做语义理解研究和工程化落地的中年人, 平日里爱把复杂问题拆成几块儿再拼回来, 口头禅是“别急, 先把骨架搭起来”. 今天我想用最像人话的方式, 把这门看似高深的技术聊清楚, 留给你几条可操作的思路.

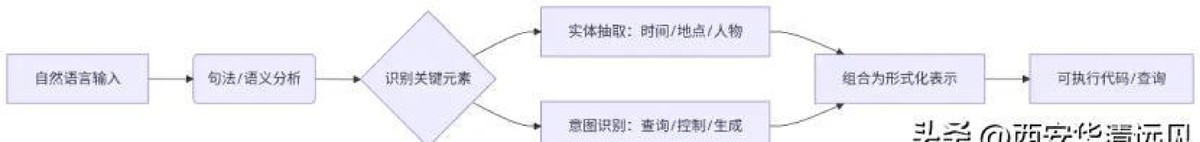

什么叫语义理解, 我习惯把它拆成三层. 第一层是字词的“意思感知”, 就像你见到“苹果”能立刻联想到水果和品牌. 第二层是句子的“关系建模”, 比如“他打破了记录”该读作庆祝的刷新, 也可能是破坏的事故, 上下文决定读法. 第三层是篇章级的“意图推理”, 那是一种把碎片粘成整体的能力, 用来回答问句、执行指令和做决策. 语义理解不是简单的词频统计, 它更像把世界的常识、语言的隐含和用户的目的三者揉在一起.

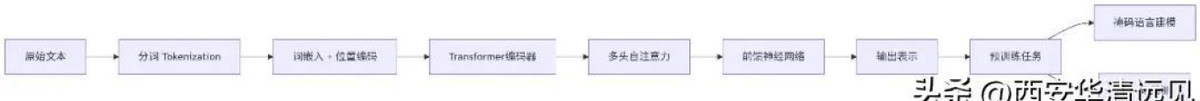

技术演进的曲线很直观. 早年我们靠词向量去做相似度匹配, 接着出现了上下文敏感的预训练模型, 它能把“bank”按河岸或银行不同场景给出不同表示. 最近几年, 大模型把语言的表层模式学得更好, 同时也暴露了短板, 那就是偶尔会自信地给出错答案, 好像一个嘴碎但不负责任的旅伴. 现实世界里, 精准的语义理解需要模型懂事实, 要有能校验和引用的知识支撑.

我常在产品评审会上丢一个“烫手的问题”, 那就是性能和可靠性怎么权衡. 很多人以为把模型越训练越大, 就能把一切语义问题解决好. 我持怀疑态度.工程里真实的提升, 往往来自三条路径: 训练数据的多样化, 结构化知识的注入, 与用户交互回路的闭环修正. 单靠模型规模, 难以把实际错误率降到产品可容忍的水平.

讲个我自己的小插曲, 昨晚我在做一个问答系统的盲测, 系统把一段法律条文错解成行政指引, 用户马上怀疑其可信度. 我当时心里有点慌, 这不是模型没见过例子的问题, 是模型缺少“法律推理链条”的能力. 我不得不把一套简短的规则和引用机制补进去, 让模型在给出结论时同时返回出处. 结果体验明显稳了. 这件事让我更坚信一件事: 可解释性和证据链, 比所谓的完美答案更能赢得用户信任.

产品落地时有三条可复制的建议, 供你参考. 一, 设计“意见分层”机制, 把模型推断分成建议型、引用型、和命令型三类, 不同场景下调整输出策略. 二, 建立轻量的知识校验层, 用事实检索去支持模型回答, 回答带上来源索引能显著降低用户质疑. 三, 把用户交互做成闭环, 每次纠错都成为训练数据的一部分, 让系统学会纠偏而不是反复犯错. 落地比理论重要, 小步快跑的迭代比一次性堆模型效果更稳.

关于未来, 我既乐观又谨慎. 我们正从“泛化”的模型迈向“个性化”的理解, 期望机器能读懂每个用户独特的意图和背景. 这要求我们不光在算法上进步, 还要在数据治理、隐私保护与公平性上负责任地前行. 技术的价值不单在于能做什么, 更在于在现实中安全且透明地做成什么.

最后, 对开发者和产品经理说两句真心话. 语义理解不是一夜之间的魔法, 它更像长期养护的园子. 把问题拆清楚, 把验证机制一层层搭好, 把用户的反馈当成养分. 我常对团队说, 别追求那种“瞬间正确率”上的虚荣, 更要追求可解释、可查证、可修正的答案. 走稳每一步, 才能把语义理解变成真正有用的能力.

我说完了, 这两年我的感受越来越强烈: 做语义理解, 要有学者的耐心和工程师的务实, 还有一点点对语言的敬畏. 如果你也做这件事, 咱们有话可以慢慢聊.

相关文章