背景

在过去的两年里,我们从零开始搭建了整个事业群的监控。目前整套系统接入 200+ 的服务,700+ 的实例,收集了上万个指标。不停探索,历经曲折,方得自由。本文主要内容是总结两年间走过的路,趟过的坑,学习到的经验。

一无所有

业务刚开始上线时,是没有任何监控的,所有的监控都是依赖接入层的Nginx的监控数据,所有的故障都是从用户获取到反馈才能发现;排查问题依靠日志系统;从上游服务开始,逐层查询日志。每次发布上线内心都在敲锣打鼓。

疲于奔命

在业务第一个大版本上线之后,我们开始着手给业务系统接入监控,此时的选择是兄弟团队搭建的 Open-,使用 作为看板。基于对立体化监控的理解,开始着手建立各种纬度的看板。

在这个阶段,我们投入了大量的人力资源到监控中,却收效甚微,主要有以下几点原因:

在这个阶段,我们投入了大量的人力,建立和维护各种看板,处理各种告警,疲于奔命,却不尽如人意。

前路始现

在第一个版本稳定之后,很长一段时间没有大需求,促使我们考虑如何解决这些问题。同时在这个阶段,在部门内部开始开发自己的 RPC 框架,基于在微信的工作经验,促使我们把目光投向 等基于数据的监控平台。

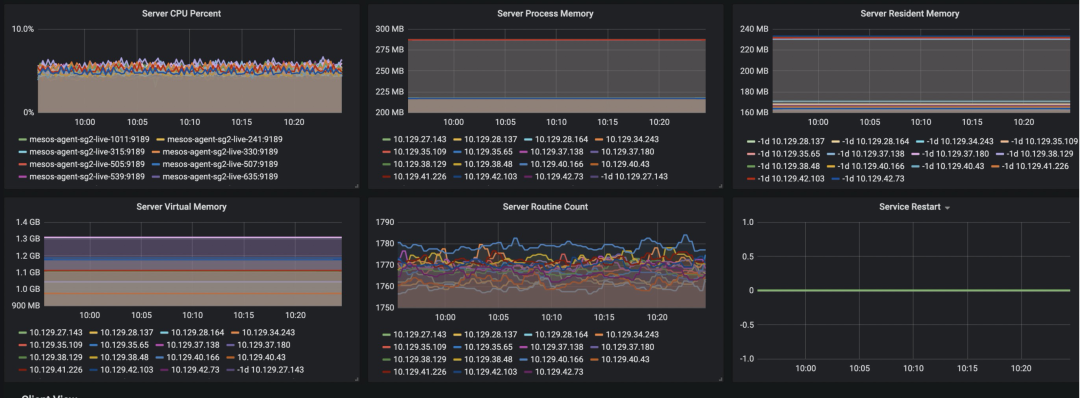

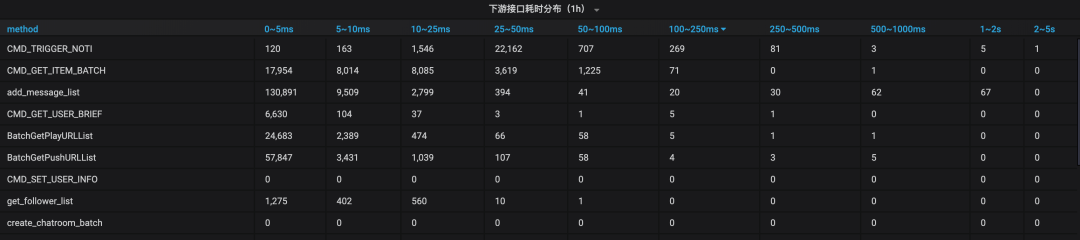

在监控方面,我们使用 SDK(数据上报) + (数据收集)+ (监控看板),构建了更灵活方便的看板。

至此,服务纬度的数据变成了可以逐渐迭代优化的统一视图,随着经验的积累,对监控的认识越深刻,看板使用越是应手。

在告警方面,使用 (数据计算) + (规则管理) + (告警管理) + (告警调用)+ 企业微信群,构建了完善的告警链条。

方得自由

在监控告警中,我们会频繁遇到以下问题:

阈值设定:不同业务场景,不同指标,如何衡量阈值是过于宽松,还是过于严格。

流量波动:在理想的世界里,流量是有起伏规律的,监控系统能够掌握这种规律,当流量上升时,告警阈值自动上升

瞬态告警:每个人都会遇到这样的情况,同样的问题隔段时间就出现一次,持续时间不过几分钟,来得快去得也快。说实话,你已经忙得不可开交了,近期内也不大会去排除这种问题。是忽略呢?还是忽略呢?

信息过载:典型的信息过载场景是,给所有需要的地方都加上了告警,以为这样即可高枕无忧了,结果随着而来的是,各种来源的告警轻松挤满你的收件箱。

故障定位:在相对复杂的业务场景下,一个“告警事件” 除了包含“时间”(何时发生)、“地点”(哪个服务器/组件)、“内容”(包括错误码、状态值等)外,还包含地区、机房、服务、接口等,故障定位之路道阻且长。

那么目前我们解决的怎么样了呢?

未来之路

基于 的数据平台能力,可以构建出业务所有服务的调用的树状图,并且当时的错误变化情况,进行自动故障根源分析,这也是我们以后将要做的。

附:

全局看板部分视图

相关文章